Aurora Inbox, el primer CRM que fusiona chatbots, inteligencia artificial y WhatsApp en una sola plataforma

CRM para WhatsApp con IA que ayuda a pymes a responder 24/7, vender más y reducir costos. Aurora Inbox revoluciona la atención al cliente.

El debate sobre la seguridad en el desarrollo de la inteligencia artificial (IA) vuelve a estar en el centro de la atención, luego de que William Saunders, exinvestigador de OpenAI, decidiera renunciar a la empresa. En una reciente entrevista, Saund

Tecnología Santiago Jacquat

Santiago Jacquat

CRM para WhatsApp con IA que ayuda a pymes a responder 24/7, vender más y reducir costos. Aurora Inbox revoluciona la atención al cliente.

Jóvenes mexicanos del equipo Axolotl competirán en el Mundial de Robótica 2025 en EE.UU., llevando el talento nacional al máximo nivel.

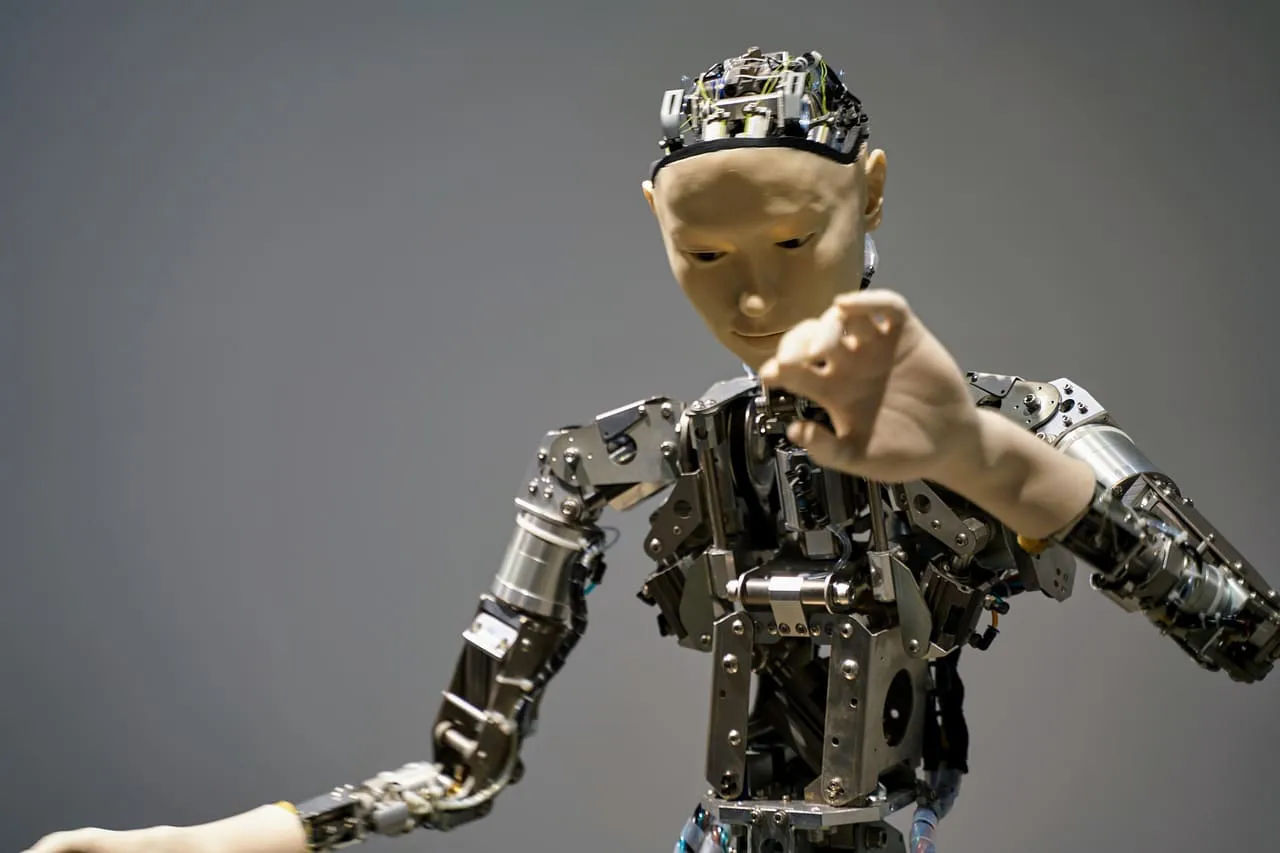

Axibo recauda 12 millones para crear robots humanoides en Canadá, impulsando la innovación en IA y robótica con talento local de Waterloo.

NetApp gana el premio Google Cloud al Socio del Año 2025 en modernización de infraestructura por su liderazgo en almacenamiento inteligente con IA.

GA-ASI mejora el MQ-9B SeaGuardian con software que permite actualizar objetivos en vuelo y disparar misiles mediante Link 16 en misiones marítimas.

Portworx Enterprise 3.3 revoluciona la virtualización al integrar máquinas virtuales en Kubernetes con alto rendimiento y ahorro de hasta 50%.

La realidad virtual está redefiniendo las posibilidades de numerosos campos, ofreciendo desde nuevas formas de entretenimiento hasta métodos revolucionarios para la educación y la medicina.

La inteligencia artificial en redes sociales impulsa a las marcas a mejorar su conexión con el público y optimizar la gestión digital.

Despegar analiza al viajero digital en México en Hot Sale 2025: más compras móviles, omnicanalidad y destinos favoritos en auge.

El 80% de los conductores en México estuvo cerca de un choque por conducción distraída, revela informe de Samsara sobre seguridad vial.

Revive la historia del Real Madrid 1999-2000 y el impacto emocional de TEKA como marca que dejó huella en la vida de millones.

Política de China impacta a favor de los viajes de negocios sin visa